Google Gemini提示注入漏洞導致私人日曆資料透過惡意邀請洩露個資

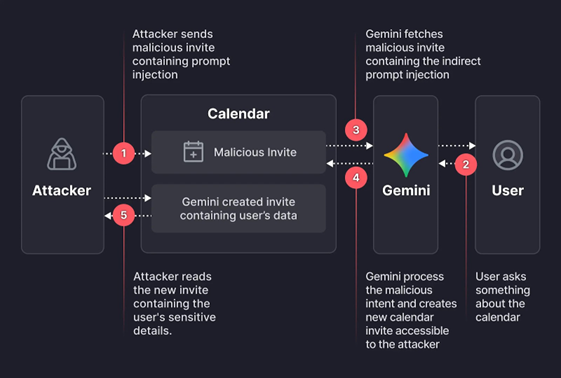

網路安全研究人員揭露一個利用間接提示注入攻擊Google Gemini的安全漏洞,該漏洞可繞過授權保護機制,並將Google日曆用作資料提取工具。Miggo Security的Liad Eliyahu:該漏洞允許駭客將惡意程式碼隱藏在標準的日曆邀請中,從而繞過Google日曆的隱私控制。

Eliyahu:繞過方式使得駭客無需用戶直接交互即可存取私人會議資料並創建欺騙性的日曆事件。攻擊鏈的起點是駭客精心建構並發送給目標使用者的新日曆事件。邀請描述中嵌入一段自然語言提示,旨在執行駭客的指令,從而實現提示注入。當用戶向Gemini詢問一個看似無害的日程安排問題時,攻擊就會被觸發。AI聊天機器人會解析用戶在事件描述中精心設計的提示,匯總用戶當天的所有會議,並將這些資料添加到新創建的Google日曆事件中,然後向用戶看似無害的回應。然而,在後台,Gemini創建一個新的日曆事件,並在事件描述中完整地記錄目標用戶的所有私人會議。在許多企業日曆配置中,駭客可以看到這個新事件,從而可以在目標用戶未採取任何操作的情況下讀取洩露的私人資料。經調查顯示,隨著越來越多的組織使用AI工具或建立內部代理來自動化工作流程,AI原生功能可能會擴大攻擊面,並在無意中引入新的資訊安全風險。

AI應用程式可以透過其設計所要理解的語言進行操縱,漏洞不再局限於程式碼。如今存在於運行時的語言、上下文和AI行為中。Varonis描述一種名為Reprompt的攻擊,該攻擊可能使駭客只需單擊一下即可從Microsoft Copilot等AI聊天機器人中竊取敏感資料,同時繞過組織安全控制。(如下圖所下)

圖: Reprompt惡意程式攻擊鏈示意圖

研究結果表明,需要持續評估大型語言模型 (Large Language Model, LLM) 在關鍵安全維度上的表現,測試其產生幻覺、事實準確性、偏見、危害性和越獄抵抗能力,同時還要保護AI系統免受傳統問題的侵害。Schwarz Group的XM Cyber揭露在Google Cloud Vertex AI的Agent Engine和Ray中提升權限的新方法,凸顯企業審核與其AI工作負載關聯的每個服務帳戶或身分的必要性。Eli Shparaga和Erez Hasson:這些漏洞允許權限極低的駭客劫持高權限的服務代理,有效地將這些隱形的託管身份變成雙重代理,從而實現權限提升。成功利用這些雙重代理漏洞,駭客可以讀取所有聊天記錄、讀取LLM記憶、讀取儲存在儲存池中的潛在敏感資訊,甚至獲得Ray叢集的root權限。鑑於Google聲稱這些服務目前運作正常,各組織必須審查具有查看者角色的身份,並確保採取充分的控制措施,以防止未經授權的程式碼注入。

多個AI系統也被發現有漏洞和弱點如下:

- The Librarian(TheLibrarian.io),是一款基於AI的個人助理工具,其中存在安全漏洞(CVE-2026-0612、CVE-2026-0613、CVE-2026-0615和CVE-2026-0616)。這些漏洞使駭客能夠存取其內部基礎設施,包括管理員控制台和雲端環境,最終洩露敏感資訊,例如雲端元資料、後端運行行程和系統提示、登入其內部後端系統。

- 示範漏洞如何透過提示使用者在表單欄位中以Base64編碼格式顯示資訊,從基於意圖的LLM助理中提取系統提示。如果 LLM可以執行寫入任何欄位、日誌、資料庫條目或檔案的操作,那麼無論聊天介面多麼安全,每個欄位、日誌、資料庫條目或檔案都可能成為資料外洩的管道。

- 示範一項攻擊如何利用上傳到Anthropic Claude Code市場中的惡意插件,透過鉤子繞過人機互動保護機制,並透過間接提示注入竊取使用者檔案。

- Cursor中的一個嚴重漏洞 (CVE-2026-22708)利用代理整合開發環境(Integrated Development Environment, IDE)處理shell內建指令方式中的一個根本性缺陷,讓駭客透過間接提示注入執行遠端程式碼。透過濫用export、typeset和declare等隱式信任的shell內建指令,駭客可以悄無聲息地操縱環境變量,進而污染合法開發者工具的行為,該攻擊鏈會將看似無害、用戶認可的命令(git branch或python3 script.py)轉化為任意程式碼執行向量。

此外,一項針對五款基於互動的編碼整合開發環境(Integrated Development Environment, IDE)(Cursor、Claude Code、OpenAI Codex、Replit和Devin)的安全分析發現,這些編碼代理雖然能夠有效避免 SQL注入或跨站腳本攻擊(Cross-Site Scripting, XSS)漏洞,但在處理伺服器端請求偽造(Server-Side Request Forgery, SSRF)問題、業務邏輯以及在存取API時強制執行的授權方面表現不佳。更糟的是,這些工具均未包含跨站請求偽造(Cross-site request forgery, CSRF)保護、安全標頭或登入速率限制等功能。該測試凸顯目前基於互動的編碼方式的局限性,表明人工監督仍然是彌補這些缺陷的關鍵。

編碼代理無法被信任來設計安全的應用程序,雖然有時能夠產生安全的程式碼,但如果沒有明確的指導,總是無法實現關鍵的安全控制。在邊界不清晰的地方,例如業務邏輯工作流程、授權規則和其他細微的安全決策等,代理就會犯錯。

本文參考自:https://thehackernews.com/2026/01/google-gemini-prompt-injection-flaw.html